Lei de Moore, computação quântica e seu papel no avanço da Inteligência Artificial.

Com o grande avanço da Inteligência Artificial nos últimos meses, acredita-se que a sociedade moderna, tem a sua frente, o avanço tecnológico mais importante em décadas, que afetará desde o aprendizado até o método que as pessoas se comunicam, desde a forma que elas trabalham até como obtém assistência médica por exemplo.

Diversos setores do conhecimento serão impulsionados pela utilização das IA’s, e assim, cada dia mais, haverá a busca por métodos de otimizar o “treinamento” de novas estruturas de inteligência artificial. Futuramente, além das IA’s buscarem as informações em uma base de dados complexa e reproduzirem o conteúdo com base em algo padronizado, desenvolverão novos dados e informações, assim como o cérebro humano é capaz. Nesse aspecto, entraria o processamento avançado dos processadores quânticos, capazes de calcular uma quantidade inúmeras vezes maior de dados que os processadores clássicos.

Para abordar o tema, é interessante conceituar que atualmente, a unidade central de processamento (CPU) é um dos principais componentes físicos dos dispositivos que executam as IA’s. Isso significa que, se por um motivo de limitação física eles não conseguirem acompanhar o desenvolvimento contínuo e rápido das IA’s, elas serão limitadas?

Não necessariamente, mas os processadores centrais, com papeis fundamentais no cálculo e execução de instruções dos softwares, também desempenha papel importante no treinamento de novos modelos de IA (desempenho do CPU afeta na velocidade de treinamento), ou seja, se um dia o processador convencional, ficar defasado em função das IA’s, possivelmente já haverá métodos adicionais para contornar essa defasagem, e um desses métodos pode ser provido pela computação quântica.

Compreendendo um pouco o surgimento do conceito e de como é descrita a evolução dos processadores convencionais, é possível compreender a trajetória dos avanços desse componente para suprir a necessidade que as invenções tecnológicas baseadas em sistemas computacionais possuem e dos problemas que são possíveis de solucionar com elas. Um exemplo é, questionar se a computação quântica utilizada em grande escala, poderá de fato, auxiliar no desenvolvimento e capacidade das IA’s.

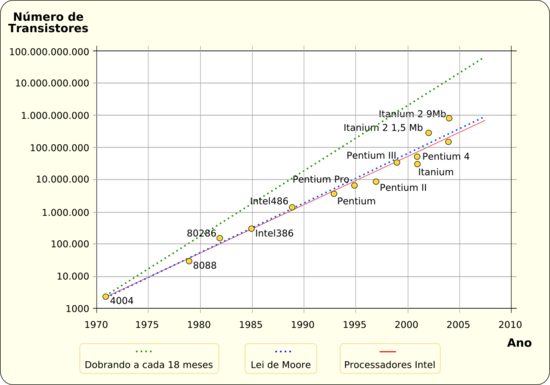

Em 1965, Gordon Moore, um dos fundadores da Intel, debateu a evolução dos processadores de computadores, e o conteúdo ficou conhecido como a Lei de Moore. Desde então os fabricantes de processadores se viram na necessidade de dobrar a capacidade de processamento dos seus processadores a cada 18 meses, em outras palavras, os processadores teriam 100% de aumento no número de seus transistores (componente responsável basicamente pelo desempenho do CPU), mantendo o custo, a cada 2 anos.

Imagem 1 – Gráfico representativo da Lei de Moore: quantidade de transístores em função do ano de lançamento do CPU

Entretanto, os pesquisadores previram o término dessa lei, entre 2020 a 2025 (observaram a impossibilidade de manter o ritmo de evolução), pois através dos cálculos realizados, seria quando os transistores do CPU, se tornariam tão pequenos, a ponto das dimensões se aproximarem as dimensões de átomos (0,1~0,2 nanômetros), isso para acompanhar o aumento de 2x, tornando o processo de fabricação inviável.

A indústria percebeu que para continuar a acompanhar a evolução no desempenho, não seria mais possível seguir a lei, que visava aumentar a quantidade de transistores. Passou a ser necessário investimento em áreas adicionais de inovação, incluindo ciência dos materiais, arquitetura de novos processadores e co-otimização de tecnologia de design (DTCO em inglês, que significa basicamente otimizar a fabricação dos componentes em conjunto as diferentes tecnologias disponíveis). As empresas passaram a desconsiderar de fato a quantidade de transistores e sim a focar na otimização de todo o processo de desenvolvimento, fabricação e montagem dos componentes que constituem o processador.

Explicitando o “término” da lei de Moore, há o indício que a concepção clássica de processadores mudará, para assim ser possível acompanhar a evolução das novas tecnologias baseadas em computação como as IA’s. Ainda é possível observar a existência de uma margem de evolução nos processadores seguindo o padrão arquitetado no passado, margem está, prevista nas otimizações dos materiais de construção dos componentes e na melhor gestão do consumo energético do CPU, por exemplo.

Devido ao exponencial crescimento de tecnologias como as IA’s, a computação está caminhando em direção a computação quântica, onde o qubit entra em cena, superando já o bit em algumas funções complexas. Grandes agentes do meio da computação já estão voltando uma considerável parte de seus recursos ($) para o estudo em pesquisas e desenvolvimento de componentes de computação quântica.

A IBM, em 2021, desenvolveu um processador de 127 bits quânticos (qubits), chamado Eagle. Comparado ao anterior mais poderoso, o processador quântico Zuchongzhi (66 qubits), foi capaz de resolver em aproximadamente 3 minutos um problema de geração de números aleatórios que os convencionais supercomputadores levariam 600 milhões de anos. O Eagle da IBM duplicou essa capacidade, e se estabeleceu como o processador mais potente até 2021, sua capacidade de processamento, para a época, já se aproximava do limite que um processador convencional conseguiria mensurar.

Fato interessante: para igualar a potência de cálculo dos 127 qubits, um processador convencional precisaria ter uma quantidade de bits clássicos maior que a quantidade de átomos contidos nos 7,5 bilhões de seres humanos vivos.

Já em novembro de 2022 a IBM apresentou o Osprey, que conta com 433 qubits, e tem planos para seguir desenvolvendo processadores cada vez com maior capacidade de processamento, além disso, há importantes esforços em estudos e pesquisas para levar e moldar o conceito de computação quântica para atividades práticas, já realizadas pelos processadores convencionais.

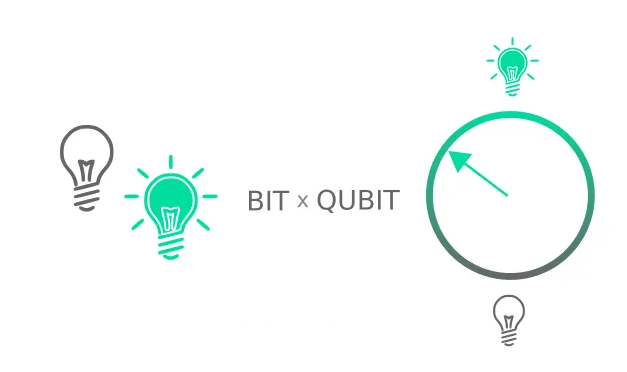

Principal diferença dos processadores convencionais para os quânticos:

Resumidamente o processador possui circuitos elétricos complexos que manipula os dados digitais em formas de “bits”, que são traduzidos em dados (números, texto, imagens, vídeos etc.) pelas instruções de linguagem de máquina, essas instruções são buscadas da memória do computador e decodificadas pelo CPU. Ou seja, o componente fundamental da estrutura funcional dos sistemas computacionais são os bits.

CPU Convencional: bits 0 ou 1

CPU Quântico: Bits passam a serem chamados de Qubits, estes podem assumir diferentes probabilidades do valor 0 e 1 simultaneamente, ou seja, a quantidade de operações e, por sua vez, o desempenho em cálculo aumenta exponencialmente a medida que se aumenta a quantidade de qubits.

Imagem 2 – Bit VS Qubit

Em comparação, um bit clássico realiza uma operação de 0 ou 1, exclusivamente ele assume o 0 ou o 1, enquanto um bit quântico pode realizar uma operação exclusiva igual ao clássico, assumindo 100% 0 ou 100% 1, porém a diferença é que ele é capaz de assumir mais uma forma que é a simultânea de 0 e 1 em diferentes taxas probabilisticas, em outras palavras, o qubit pode ser 50% 0 e 50% 1 meio a meio (pode assumir qualquer probabilidade entre 0% e 100% dos valores 0 e 1), desde que essa forma não seja medida ou interpretada antes do esperado, caso contrário o qubit colapsa e assume um valor antes do projetado. Esta concepção é totalmente diferente do convencional, e é explicada pela teoria da superposição quântica ou superposição de estados.

Superposição quântica

Exemplificando: Gato de Schrödinger

Se trata de uma caixa opáca com um gato dentro, com uma substância venenosa em um frasco, um martelo fixado em um mecanismo que, se o medidor de radiação presente indicar radiação no ar, soltará o martelo e ele cairá e quebrará o frasco, liberando a substância venenosa, aleatoriamente, pois não se sabe se o ar tem radiação ou não antes da medição. O observador, cuja visão é externa a caixa apenas, só saberá se o gato está vivo ou morto se a caixa for aberta, caso contrário (eliminando qualquer outra variável) será um gato vivo e morto ao mesmo tempo, 50% de chance de ele estar vivo e 50% de não. Lembrando que este é um experimento mental, e aplicado a corpos que sejam pequenos o suficiente, para a interação com o espaço não colapsar o estado de superposição.

O que teoriza a situação em que o bit pode ser 0 e 1 ao mesmo tempo assim como o “gato de Schrodinger”, é teorizado através da superposição quântica, em que, uma partícula (elétron – eletricidade ou fóton – luz) pode estar em diferentes estados ao mesmo tempo, até ser medida ou observada, que é quando ela se “estabiliza” e é fixada em um estado clássico.

No exemplo dos processadores quânticos, os qubits, irão desempenhar papel fundamental no processamento de dados quânticos, em outras palavras, o circuito do processador quântico irá manipular a corrente elétrica de forma que o dado quântico chegue ao destino projetado, e esse dado só será compreensível quando ele chegar no destino, for medido e interpretado.

É possível pensar que determinada função será realizada com o qubit possuindo a probabilidade de estar 20% 0 e 80% 1 e quando o qubit chegar no destino arquitetado será medido e interpretado, assim ele assumirá o valor 0 ou 1 como um bit clássico, com maiores chances de carregar o valor 1 nesse caso (na prática mesmo havendo maiores chances ele poderá assumir o valor 0 também no final).

Ainda em estudos iniciais, a utilização de incertezas no processo de geração e interpretação dos dados quânticos, não é demonstrado os benefícios práticos nas aplicações convencionais de dados, ou seja, atualmente os dados são emitidos de uma forma e recebidos da mesma para que a função específica ocorra na aplicação, algo que não ocorre no processamento quântico pois o dado apesar de ter um estado fixo na emissão, ele durante o processo de transporte carrega consigo a incerteza associada a probabilidade dos estados, portanto, terá um estado superposto antes de ser coletado e medido, e somente após a interpretação do dado ele assumirá o valor correspondente.

Como, ao passar dos anos a maior parte do que se observou dos fenômenos naturais, foi observado a olho nú (objetos macroscópicos que interagem bastante com o espaço), estudado e explicado amplamente pela física clássica, as novas leis físicas propostas pela quântica ainda estão em estágios iniciais de difusão para a explicação de fenômenos no mundo subatômico (muito pequeno). A compreensão do funcionamento das tecnologias, ainda é fielmente baseado nas leis clássicas, entretanto, no estágio atual de desenvolvimento dos componentes eletrônicos do próprio CPU convencional, a explicações propostas pela física quântica, estão dia após dia auxiliando mais no avanço tecnológico destes componentes.

Conclusão

Apesar de, na teoria o processador quântico ter um desempenho acima do convencional em algumas tarefas de cálculo e processamento, na prática, isso atualmente se resume a casos extremamente específicos, como geração aleatória de números, fatoração de números super extensos e simulação quântica (útil em áreas de modelagem de materiais etc.), maior parte na área em que a incerteza é uma variável importante e útil (ciência-pesquisa), o segredo para saber se a computação quântica terá o grande impacto que se espera dela, é descobrir como aplicar a variável: incerteza nas aplicações usuais, visto que as aplicações atuais utilizam como base a certeza.

Casos em que são desempenhados funções convencionais (tarefas cotidianas), os benefícios do cálculo avançado do processador quântico ainda não é justificado, pela dificuldade de se estabilizar o sistema computacional quântico fora das condições de laboratório, necessidade de adaptar as linguagens de máquina para trabalharem com os qubits, incertezas associadas etc. Tudo indica que, conforme os estudos e pesquisas avancem na área de computação quântica, o processamento quântico será essencial para a solução de problemas ainda não solucionados, novos problemas e chegada de novas tecnologias como softwares de IA’s mais avançados.

Hodiernamente, os estudos e pesquisas sobre computação quântica estão nos estágios iniciais assim como os estudos de inteligência artificial. Portanto, mesmo com a inovação apresentada, nas características avançadas do processamento quântico, ainda não é possível determinar se a computação quântica em grande escala será um divisor de águas em aplicações moldadas convencionalmente com base na computação clássica como as IA’s são atualmente.

Seja o primeiro a comentar